Ons eerdere werk

Door de jaren heen hebben wij gewerkt met veel verschillende typen organisaties. De overeenkomst? De wens om beter en slimmer hun werk te kunnen doen. Met data, machine learning en AI.

Lees hier hoe wij hen hielpen!

Scroll door alle projectenkeyboard_arrow_rightGezondheid en zorgkeyboard_arrow_rightIndustriekeyboard_arrow_rightAI-productenkeyboard_arrow_rightLaat onze case studies je inspireren voor jullie volgende stap met data en AI. Wil je direct jouw eigen casus bespreken?

Selectical | Literatuuronderzoek | NLP | Active Learning

Literatuuronderzoek in 1/3 van de tijd

Onderzoekers die (systematisch) literatuuronderzoek doen, moeten vaak véle duizenden artikelen screenen om die artikelen te vinden die relevant zijn voor hun onderzoek. Daarbij moeten ze grondig zijn, omdat er vaak niets gemist mag worden. Echter zijn van die duizenden papers vaak slechts een paar honderd relevant. Deze selectie handmatig doen kost ontzettend veel nuttige tijd en is simpelweg niet leuk.

Zonder vooraf gelabelde data

Normaal gesproken train je een AI-model op basis van gelabelde data. Op basis van voorbeelden. Maar dat kan in dit geval niet! De uitdaging is namelijk dat gezien elke literatuurstudie anders is, er geen voorbeelden zijn. Dat labelen van die voorbeelden is eigenlijk precies je werk. Maar dat betekent niet dat je dan geen AI kunt trainen!

En toch AI inzetten

Hiervoor hebben we Active Learning gebruikt: een type AI dat leert van menselijke input en zich continu verbetert tijdens het werken. Zo kan de onderzoeker op dezelfde manier aan de slag met hun werk, terwijl de AI meeleert. Op het moment dat de AI zeker genoeg is dat het de juiste patronen heeft opgepikt, neemt deze het labelen van de artikelen over en hoeft de onderzoeker dit alleen nog te valideren of corrigeren. Scheelt een hoop werk!

Lees meer over Selecticalkeyboard_arrow_rightVraag direct een demo aankeyboard_arrow_right

Gezondheid & Zorg | Privacy | NLP

Honderdduizenden medische dossiers automatisch labelen

Ziekenhuizen in Nederland zijn bij wet verplicht om universele diagnosecodes toe te wijzen aan patiëntdossiers (en dit te rapporteren aan de NZa en het CBS). Ziekenhuizen hebben hier specifiek getrainde mensen voor in dienst, die deze codetoekenning handmatig doen. Dit – vaak saaie – mensenwerk kost veel tijd en is (daardoor) ook nog eens vatbaar voor fouten.

DHD wilde een manier vinden om de ziekenhuizen en deze codeurs te ondersteunen bij deze bewerkelijke taak. Bijvoorbeeld in de vorm van een tool die 'makkelijke gevallen' automatisch verwerkt en codeurs ondersteunt bij lastigere gevallen.

Met behulp van AI, zonder privacyschending

Dit kan met AI. Er bestaan namelijk al miljoenen gelabelde patiëntendossiers (voorbeelden) waarvan geleerd kan worden. Deze voorbeelden:

- bevatten echter wel gevoelige data van patiënten en artsen die je niet mee mag nemen, en

- zijn verdeeld over een hoop verschillende ziekenhuizen die hun data niet zomaar mogen delen.

Daarom hebben we gebruik gemaakt van:

om een tool te ontwikkelen die uit de vrije tekst van patiëntendossiers (bijv. ontslagbrieven en OK-verslagen) kan herkennen welke ICD-10-codes van toepassing zijn en deze toekent.

Tijdswinst met zekerheid en uitlegbaarheid

Bij het ontwikkelen van een AI-model moet je altijd oppassen dat het de juiste dingen leert. Zeker als het om gevoelige toepassingen gaat, moet je ervoor zorgen dat het zo min mogelijk fouten maakt. En dat je snapt waarom een model bepaalde beslissingen maakt. Pas dan kan je taken volledig automatiseren. Als je dat überhaupt al zou willen.

Met de voorwaarde dat het model 80% zeker moet zijn, kon ons AI-model al snel meer dan 30% van de codes volledig automatisch toekennen. Dat klinkt misschien laag, maar stel je voor dat je een derde van je werktijd zou kunnen besparen!

Voor gevallen waar de zekerheid van de AI onder de gewenste drempel valt, wordt de gebruiker een top 5 van waarschijnlijkste codes voorgelegd (met uitleg!), zodat de juiste gemakkelijk handmatig gekozen kan worden. Dit bespaart nog steeds veel tijd t.o.v. het met de hand opzoeken van het juiste label zonder voorselectie.

Industrie | Inzicht | Predictie

Kostbare mijnoperatie beter beheersen

RAG, ooit Duitslands grootste mijnbouwbedrijf voor steenkool, moet dagelijks tonnen water uit oude mijnschachten pompen om aan veiligheidsregels te voldoen. Het precieze proces waarmee water de mijn instroomt is echter niet goed begrepen. Landscape heeft een model gemaakt van real-world data om die hoeveelheid water maanden van tevoren te voorspellen. Hoeveel water er gepompt zal moeten worden is hiermee ook van tevoren duidelijk, waardoor RAG hun resources beter en efficiënter kan managen!

Lees er alles overkeyboard_arrow_right

Industrie | Procesoptimalisatie

Een AI een energiecentrale leren aansturen

Voor iedereen geldt: hoe vaker of langer je iets doet, hoe beter je erin wordt. Je maakt verschillende situaties en contexten mee, weet die vervolgens vrij snel te herkennen en leert hoe je daarop moet reageren.

Mensen kunnen dit vrij snel – met minder voorbeelden leren. Maar patronen herkennen zijn computers weer beter in. Zeker als het om veel variabelen gaat.

Voor het besturen van een energiecentrale geldt dit net zo. We weten inmiddels goed wat er hoe moet gebeuren, maar kunnen we misschien nóg beter de energie beheren? Kunnen we nóg eerder aan zien komen wanneer er iets fout gaat? Kunnen we onze operatie duurzamer doen? En kan een AI dit ontdekken?

Met Digital Twins en Reinforcement Learning

Bingo! Hypewoordstempelkaart vol.

Maar het ís wel zo. Samen met EKu.SIM – die Digital Twins ontwikkelt voor kritieke infrastructuren – zijn we aan het uitzoeken hoe we door een AI 'vrij' te trainen met vele simulaties nóg beter kunnen worden in het besturen van energiecentrales. Kleine verbeteringen kunnen in deze branche namelijk al grote verschillen maken!

Cultuur | Voorspellen

Bezoekersaantallen voorspellen

Hoe druk zal het in het park zijn? Hoeveel gasten kunnen we deze week verwachten? Een dierentuin wilde kunnen voorspellen wat de drukke en rustige momenten van de weken erop zouden zijn.

Op basis van het verleden

Om dat te kunnen doen hebben we:

- Hun historische data gecombineerd met datasets als het weer, vakanties, evenementen in de stad, etc.

- Onderzocht welke factoren de grootste impact hebben op bezoekersaantallen

- Een AI-model ontwikkeld dat het aantal bezoekers per uur voorspelt

- Alle historische data, de voorspellingen en de externe factoren in een handig dashboard toegankelijk gemaakt

Om beter te kunnen plannen

Met dit AI-model kon de dierentuin twee weken vooruit, per uur, voorspellen hoeveel bezoekers ze zouden hebben en van welk type. Dit is handig als je betere planningen voor bijvoorbeeld je personeel, aanbiedingen, prijzen of inkoop wilt maken.

En je klanten nóg beter te snappen

Niet alleen is het fijn om beter te kunnen plannen en zo grote overschotten en tekorten te voorkomen: door patronen in je data te zoeken, kan je ook nog eens tot nieuwe inzichten komen. Jij kent je klanten natuurlijk als geen ander, maar vaak zien we dat er toch nog dingen uit data komen, waar de experts nog niet van op de hoogte waren. Bonus!

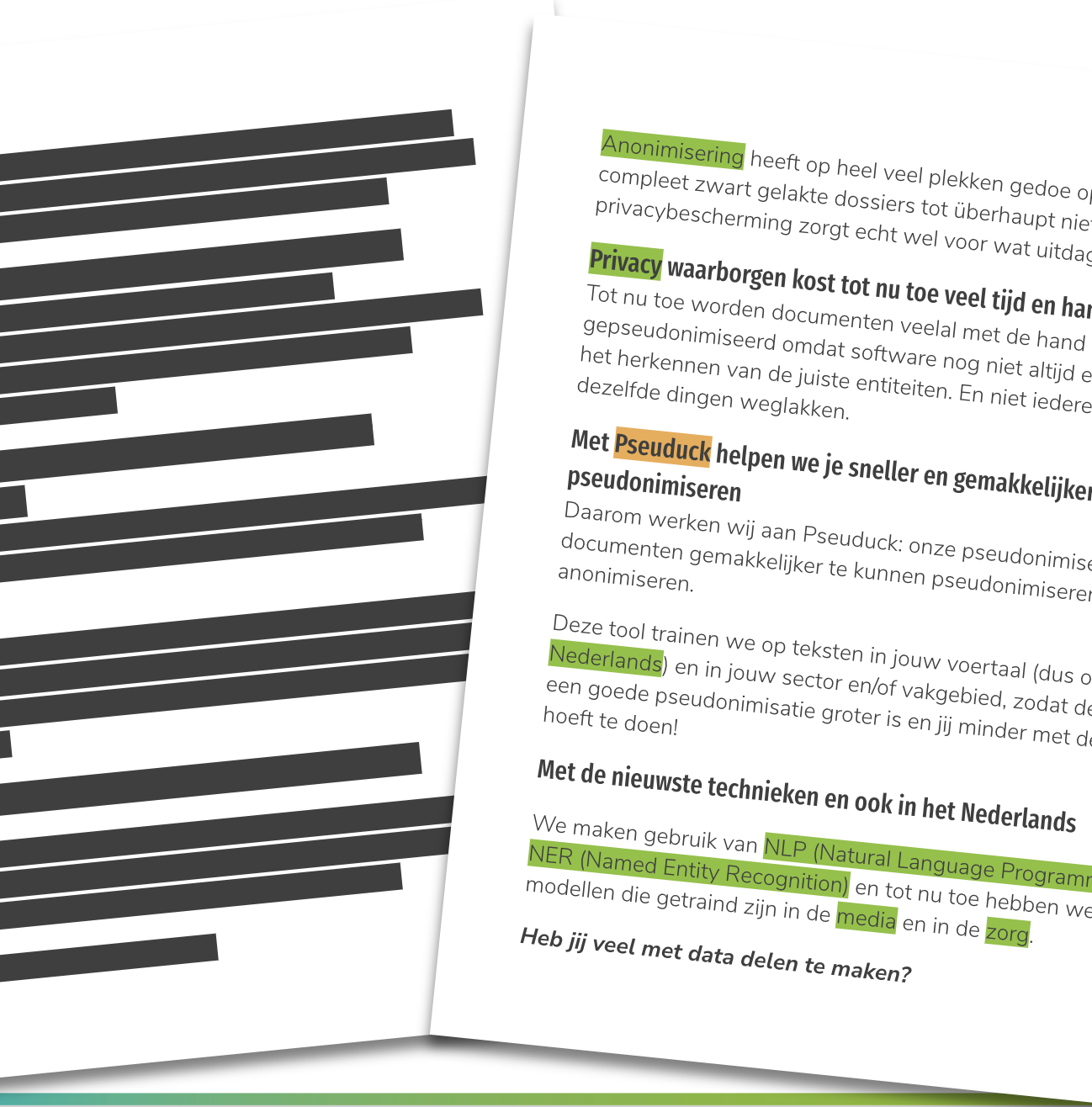

Pseuduck | Pseudonimiseren | Anonimiseren | Privacy

Privacy waarborgen bij data delen

Data of bestanden delen, kan niet altijd zomaar. Vaak bevat deze namelijk persoonsgegevens of overige privacyschendende informatie. Als je aan de AVG wilt voldoen, moet je dus eerst wat werk steken in het anonimiseren of pseudonimiseren van de data, voordat je er iets mee mag doen.

Tot nu wordt het meeste anonimiseringswerk met de hand gedaan. Dit is een hoop werk, kost veel tijd en is – net als elke langdurige rotklus – gevoelig voor fouten. Zeker als het gaat om vrije tekst!

Pseuduck to the rescue voor AVG-proof teksten

Pseuduck is een door ons ontwikkelde pseudonimiseringstool die het gemakkelijker maakt om jouw vrije teksten – van kleine tekstvelden tot grote (collecties van) documenten – AVG-proof te maken.

Het mooie van Pseuduck is dat we het kunnen bijtrainen in verschillende vakgebieden én in het Nederlands, om jouw teksten, in jouw vakjargon en naar jouw behoeften te kunnen pseudonimiseren of anonimiseren.

Wat voor gevoelige teksten moet jij mee werken?

Neem contact op voor een trial!keyboard_arrow_right

Gezondheid & Zorg | Sensordata

Biometrische sensoren in klinisch onderzoek

Hoe kunnen we wearables inzetten in klinisch onderzoek? Onze klant doet veel medisch onderzoek bij proefpersonen en wil graag sensordata voor studies kunnen gebruiken en de grote hoeveelheden data die dat oplevert effectief kunnen verwerken.

Wat hebben wij gedaan?

- De data onderzocht op bruikbaarheid

- Geholpen bij het ontwerp van een onderzoek om dit soort sensordata klinisch te valideren

- Strategisch advies over een in te richten Big-Data-omgeving en te gebruiken tooling

Gebaseerd op onze resultaten is een klinische studie gestart waarin het doel is om patiënten te onderscheiden van gezonde proefpersonen.

Samen met de klant ontwikkelen we AI-modellen om op basis van biometrische sensoren patiënten direct te kunnen diagnosticeren.

Industrie | Data Management

Bewaar alleen de data die je nodig hebt

Airborne Oil & Gas, fabrikant van pijpleidingen, wilde sensoren en camera's in hun fabriek gaan inzetten om data over hun productieproces te verzamelen. Deze data kan gebruikt worden om een AI verschillende taken uit te laten voeren en om een Digital Twin te bouwen: een virtuele kopie van het fabrieksproces.

Maar voor zoiets kon gebeuren moesten ze eerst grote hoeveelheden data opslaan die door deze sensoren worden gegenereerd. Ze vroegen ons om vast te stellen hoeveel opslagcapaciteit er nodig zal zijn, welke data dan precies opgeslagen moet worden, en wat daarvoor de optimale methode is.

Lees er alles overkeyboard_arrow_right

Bedrijfsvoering | Beeldanalyse

Alle daken van Nederland gemeten en beoordeeld

Hoe hoog is een gebouw? Wat voor dak zit erop? De klant, een data-aggregator, wilde een dataset met daarin hoogteprofielen en daktypes van alle gebouwen in Nederland.

Wat hebben we gedaan?

- Data uit satellietbeelden gekoppeld met (open) kaartdata en daarmee de hoogte van elk Nederlands gebouw bepaald

- Tienduizenden 'gelabelde voorbeelden' verzameld van types van daken uit verschillende bronnen

- Een AI getraind om de meest gangbare daktypes automatisch te herkennen

Ons model bouwde de gevraagde dataset door het type dak van elk gebouw in Nederland te categoriseren. Met deze nieuwe data kan de klant hun eigen modellen verbeteren, waarmee ze bijvoorbeeld kunnen zien hoe waarschijnlijk het is dat iemand binnenkort gaat verhuizen.